可解释的人工智能

目录

可解释的人工智能

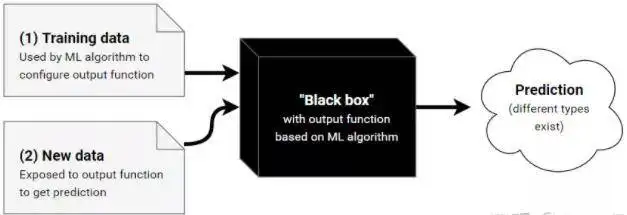

可解释的人工智能(XAI),或可解释的人工智能,或可解释的机器学习(XML),是指人类可以理解人工智能做出的决定或预测的人工智能(AI)。它与机器学习中的黑匣子概念形成对比,在机器学习中,即使其设计者也无法解释为什么人工智能会得出一个特定的决定。通过完善人工智能系统用户的心智模型,拆除他们的错误观念,XAI有望帮助用户更有效地执行。XAI可能是对社会解释权的实施。即使没有法律权利或监管要求,XAI也是相关的。例如,XAI可以改善产品或服务的用户体验,帮助终端用户相信人工智能正在做出好的决定。这样一来,XAI的目的是解释已经做了什么,现在做了什么,接下来会做什么,并揭开行动所基于的信息。这些特点使它有可能(一)确认现有的知识(二)挑战现有的知识和(三)产生新的假设。人工智能中使用的算法可以被区分为白盒和黑盒机器学习(ML)算法。白盒模型是ML模型,它提供的结果对该领域的专家来说是可以理解的。另一方面,黑盒模型则极难解释,即使是领域专家也很难理解。XAI算法被认为是遵循透明、可解释和可说明的三个原则。如果”从训练数据中提取模型参数和从测试数据中生成标签的过程可以被方法设计者描述和激励”,那么就有了透明度。可解释性描述了理解ML模型的可能性,并以人类可以理解的方式呈现决策的基本依据。可解释性是一个被认为很重要的概念,但目前还没有一个共同的定义。有人建议,ML中的可解释性可以被认为是”可解释领域的特征的集合,这些特征对一个给定的例子产生决策(例如,分类或回归)有贡献”。如果算法满足这些要求,它们就为证明决策、跟踪从而验证决策、改进算法和探索新事实提供了基础。

有时也有可能用白盒ML算法实现高准确度的结果,而这种算法本身是可以解释的。这在医学、国防、金融和法律等领域尤其重要,在这些领域,理解决策和建立对算法的信任是至关重要的。许多研究人员认为,至少对于有监督的机器学习来说,未来的方向是符号回归,其中算法搜索数学表达式的空间以找到最适合给定数据集的模型。人工智能系统优化行为,以满足系统设计者选择的数学上指定的目标系统,如命令xxx限度地评估测试数据集中的电影评论的积极程度的准确性。人工智能可以从测试集中学习有用的一般规则,例如包含”可怕”一词的评论可能是负面的。然而,它也可能学习到不恰当的规则,例如含有”丹尼尔-戴-刘易斯”的评论通常是正面的;如果这些规则被认为可能无法在测试集之外进行推广,或者人们认为该规则是欺骗或不公平的,那么这些规则可能是不可取的。人类可以审核XAI中的规则,以了解系统在测试集之外对未来真实世界的数据进行概括的可能性如何。

可解释的人工智能的目标

xxx之间的合作,在这里是指算法和人类之间的合作,取决于信任。如果人类要接受算法处方,他们需要信任算法。信任标准形式化的不完全性是直接优化方法的一个障碍。出于这个原因,透明度、可解释性和可解释性被认为是检查其他标准的中间目标。这在医学上尤其重要,尤其是临床决策支持系统(CDSS),医学专家应该能够理解基于机器的决策是如何和为什么做出的,以便信任该决策并增强他们的决策过程。人工智能系统有时会学习不理想的技巧,在训练数据上做了满足明确的预编程目标的最佳工作,但并不反映人类系统设计者的复杂的隐性愿望。例如,2017年一个负责图像识别的系统通过寻找恰好与马匹图片相关的版权标签来学习作弊,而不是学习如何分辨图片中是否真的有马。在另一个2017年的系统中,一个负责在虚拟世界中抓取物品的监督学习人工智能学会了作弊,将其操纵器放在物体和观众之间。